自动驾驶车的责任和风险分析

说到“自动驾驶”,人们最熟悉的名字恐怕是 Tesla 的 Elon Musk 先生了。他总是对 Tesla 的 Autopilot 进行各种夸大宣传,让人误解 Autopilot 的能力。Autopilot 引起车祸死了人之后,Musk 先生总是在网上发话扭曲人们的逻辑,抓住“车主没有及时接管”等各种借口,逃避对事故的责任。

很多人对他的言论感到荒谬和愤怒,却又难以说清楚他到底哪里错了,甚至政府监管机构都对各自动驾驶公司的歪理无能为力。我发现对于自动驾驶车的责任和风险问题,人们仍然缺乏一个精确的,使人信服的说法,所以我一直在思索这些问题。

在本文里,我试图使用逻辑和概率的工具来分析自动驾驶车的责任和风险问题。虽然我用的数学可能不是那么的细节到位,但是你可以从中获得分析这类问题的思路。逻辑推理和概率分析不仅可以用于科学研究,而且可以用于法律和各种社会现象。

根据对 Elon Musk 的采访,你可以看出他的言论大体包含以下内容:

- 全自动驾驶很快就要实现了,Autopilot 的视觉识别能力成指数增长,所以实现全自动驾驶就在眼前。

- 现在出产的 Tesla 车已经安装了具有“全自动驾驶能力”(FSD)的硬件。只要我们在不久的将来更新车里的软件,你就能拥有全自动驾驶的车,所以现在买 Tesla 的车是一种升值的财富,而不是贬值的物品。

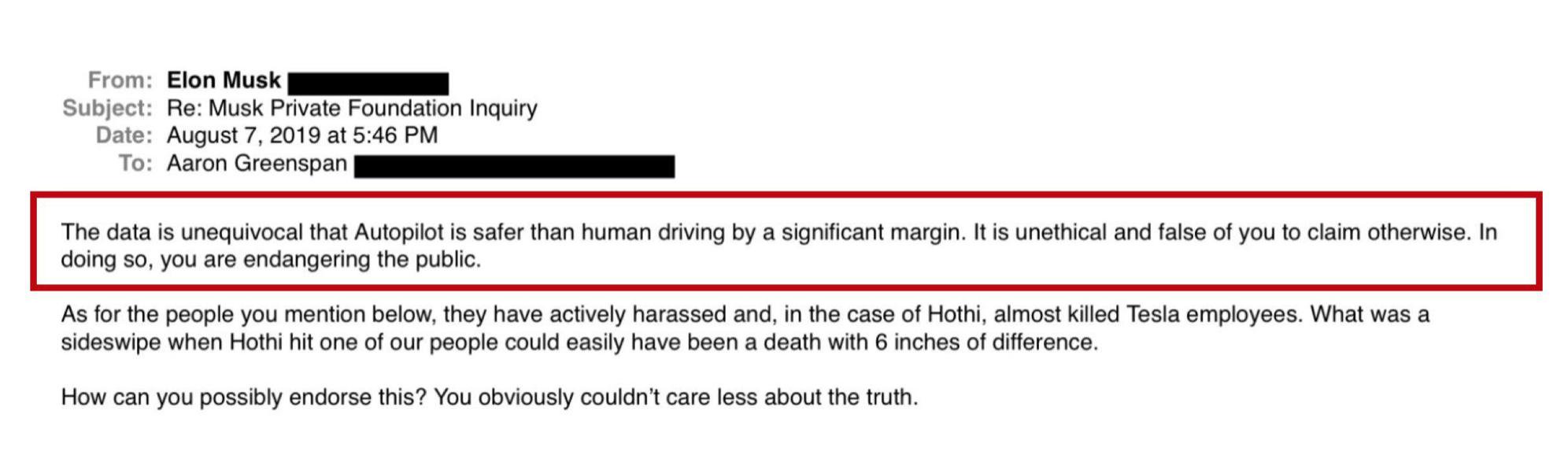

- 统计数字显示,Autopilot 的事故率远远低于人类驾驶员。Autopilot 比人类驾驶员安全很多,这是不可争辩的事实。如果你否认这个事实,你就是危害公共安全。

虽然各种证据都说明 Autopilot 几乎没有自动驾驶能力,Elon Musk 却仍然在宣扬这些歪理。很多书呆子极客会听信他的“事故率”,为他所谓的“高科技”欢呼,甚至有人跟风说“Autopilot 比人类驾驶员安全 6 倍”。这些人都不明白,统计数字对于事故责任分析,对于 Autopilot 的风险评估都是没用的,而且他们的统计方法,解释统计数字的方式都是错误的。

在本文中我想说明以下几点:

- 大范围的统计数字对于“责任”和“风险”的分析是没有任何关系的。

- Autopilot 导致的任何一次车祸,Tesla 公司在法律上都是负有责任的。

- 要求驾驶员“随时接管”是推脱责任的手段,根本不符合法理。

- 自动驾驶行业对于车祸死亡率的数据解释是片面而错误的。由车祸引起的死亡,相对其它死亡因素并不是特别严重的问题。自动驾驶技术并不能降低车祸死亡率。

责任

Elon Musk 和其他很多自动驾驶公司都喜欢拿“事故率”说事,总是说自动驾驶比人类驾驶员安全,因为统计数字显示它们的事故率低,其实那相当于在说:“我活了这么久,为这么多客户服务,没杀过其中任何一个人,我杀人的概率非常低,低于全国的谋杀犯罪率,所以我现在杀了你没什么大不了的。”

先不说 Autopilot 的事故率是否真的那么低。即使它事故率是很低,难道弄死了人就可以不负责,甚至不受谴责吗?

到底 Tesla 有没有责任,我们可以使用逻辑学的因果关系“反事实分析”(counterfactual analysis)。假设驾驶员没有使用 Autopilot 而是自己开车,那么这次事故还会不会发生?如果不会发生,那么我们得到因果关系:Autopilot 导致了事故。不管其他人用 Autopilot 有没有出事故,事故占多大比例,面对这里的因果关系都是无关紧要的。因果关系等于责任。

如果是 Autopilot 导致了事故,即使总共只发生了一次事故,都该它的设计者 Tesla 公司负责。很多人都是混淆了“责任”和“事故率”,所以才会继续支持 Elon Musk 和 Tesla 的谬论。有些人以为“自动驾驶可能会降低全国的车祸率”,从而认为 Autopilot 引起少数几次车祸问题不大,而不明白“事故率”跟“责任”和“事故再次发生的风险”,完全是两码事。

另外,如果你看透了这些吹嘘得神乎其神的“机器的视觉能力”有多假,就会知道“自动驾驶会降低车祸率”这个说法根本就不可能实现。

为什么我强调“责任”呢?因为人如果自己开车,不小心出了车祸伤到自己,他自己是可以接受的,因为是自己的责任。然而要是 Autopilot 判断错误引起车祸,撞伤了自己,对于车主来说这就是不可接受的,必然要追究 Tesla 公司的责任。

任何人都明白这个道理吧?这就跟自己开车不小心受了伤,和出租车司机不小心导致你受伤的差别一样。你会告那个出租车司机,你却不会上法庭告自己。简单吧?

每一次 Autopilot 相关的事故,Tesla 公司都会在事后散布新闻说是驾驶员开车不认真,手没有在方向盘上准备“随时接管”,所以不是 Autopilot 的责任。驾驶员是否认真在开车,人死了无所对证,但这些全都成为了 Tesla 公司推脱责任的借口。

如果发现 Autopilot 判断失误,你真来得及接管吗,你能在那么短的时间内做出正确的反应吗?就算你双手都在方向盘上,车到了离障碍物多近的地方不减速,你才会意识到它出错了,决定接管呢?恐怕到了自己接管的时候就已经晚了。所以要求车主随时接管,根本就不是一个合理的要求,不应该作为 Tesla 免责的理由。

Autopilot 的个人风险分析

为什么每年几万起其它车祸没什么人关心,而 Autopilot 引起一两次车祸就这么多新闻舆论呢?因为要是车祸是由于 Autopilot 引起的,那么同样的车祸就可能发生在所有使用 Autopilot 的 Tesla 车主身上,“Autopilot 再次发生车祸”的后验概率就会大大提高。Autopilot 导致自己伤亡的风险就很高了。

这里的核心问题就在于,到底是人开车还是 Autopilot 开车。人和软件不仅在技术能力上有很大差别,对于概率风险分析,人和软件的效果也是很不一样的。简言之,人是“独立随机变量”,而 Autopilot 不是独立变量。

每个人都是不一样的,是独立的个体。有的人开车很稳,有的人开车一般,而少数人很鲁莽。这些人之间没有必然的联系,是“独立随机变量”。什么叫“独立”呢?意思是某个人自己开车不小心出车祸,其他人并不一定会出同样的车祸,因为每个人的开车方式都不一样。在概率论里面,这些人是否出现车祸完全是独立的事件。

而 Autopilot 是一个软件系统,所有安装 Autopilot 的车都有一模一样的行为方式,所以使用 Autopilot 的许多 Tesla 车不是独立变量,而是“相关变量”,它们通过 Autopilot 系统的设计关联在了一起。如果 Autopilot 因为判断错误导致一次车祸,那么所有使用 Autopilot 的车都很可能发生同样的车祸。

相应的随机变量是否“独立”,导致了人类驾驶员与 Autopilot 出现一次事故的风险分析完全不一样。

如果你学过概率论,那么 Autopilot 车主出事的“后验概率”(posterior probability)会因为“Autopilot 引起一次车祸”的发生而大幅度提高,而如果是人开的汽车,那么它的后验概率基本不会因为另外一辆同型号车出事而提高。写成数学公式就是:

P(其它 Autopilot 出车祸 | Autopilot 引起一次车祸)

远大于

P(其它非自动车出车祸 | 一辆非自动车出车祸)

事故起因的随机性不同,后验概率也就随之不同。

面对“Autopilot 有一定概率会要了你的命”这一事实,不管 Autopilot 的总体事故率有多低,甚至像 Elon Musk 说的低于全国车祸率,对于 Tesla 车主来说都是毫无意义的。一是因为“责任”:车主可以允许自己要了自己的命,却不允许 Autopilot 或者其他人要了自己的命,更不允许是因为别人(Autopilot)的愚蠢而要了自己的命。二是因为“个人风险”:不管全国的事故率是多少,自己开车的风险一般只跟自己开车的小心程度有关,也就是说自己开车出事的概率基本是独立于全国事故率的。而使用 Autopilot,自己的风险就受到 Autopilot 能力的影响,跟 Autopilot 的平均事故率差不多了。

仔细看看统计数字

Autopilot 的事故率真的低吗?你可以自己研究一下。如果你算对了数学,恐怕它的事故率并不低。举一个例子,普通人只计算了事故的数目与 Autopilot 导航的总里程的比例,却忽视了那些由于驾驶员及时接管而避免了的事故的数目。

Autopilot 能不受打断的连续驾驶多少里程呢?按照现有的视觉技术,恐怕不会很远。聪明点的人都不会让 Autopilot 进入稍微复杂的局面,只用它进行“高速车道控制”,所以 Autopilot 事故率比较低的原因,很可能是因为大部分用户根本不在复杂的情况下使用它。所以虽然 Autopilot 统计数据看起来是“几十亿英里”,恐怕它从来没有在复杂的情况下做出过正确的反应。

另外 Tesla 属于比较贵的车,买车的人属于对自己比较负责的人,所以事故率不应该跟所有车比,而应该跟同样年代的奔驰,保时捷之类的车比。

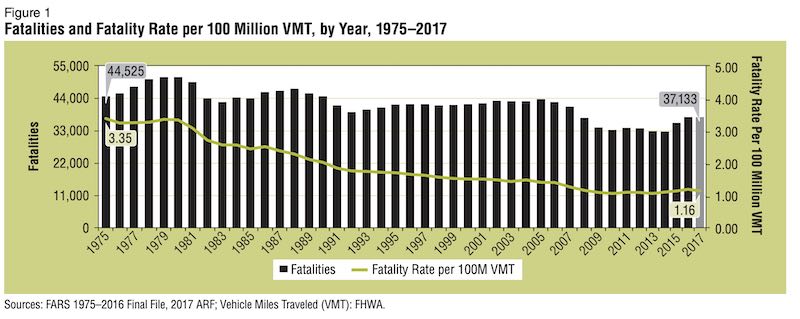

我们来仔细看看汽车业的总体统计数字吧。美国 2017 年车祸死亡人数是 3.7 万人。看上去很多,可是按里程数的死亡率,每一亿英里平均只有 1.16 人。从 1975 年到 2017 年,每一亿英里死亡人数从 3.35 人降低到了 1.16 人,所以即使没有 Autopilot,开车也是越来越安全了。

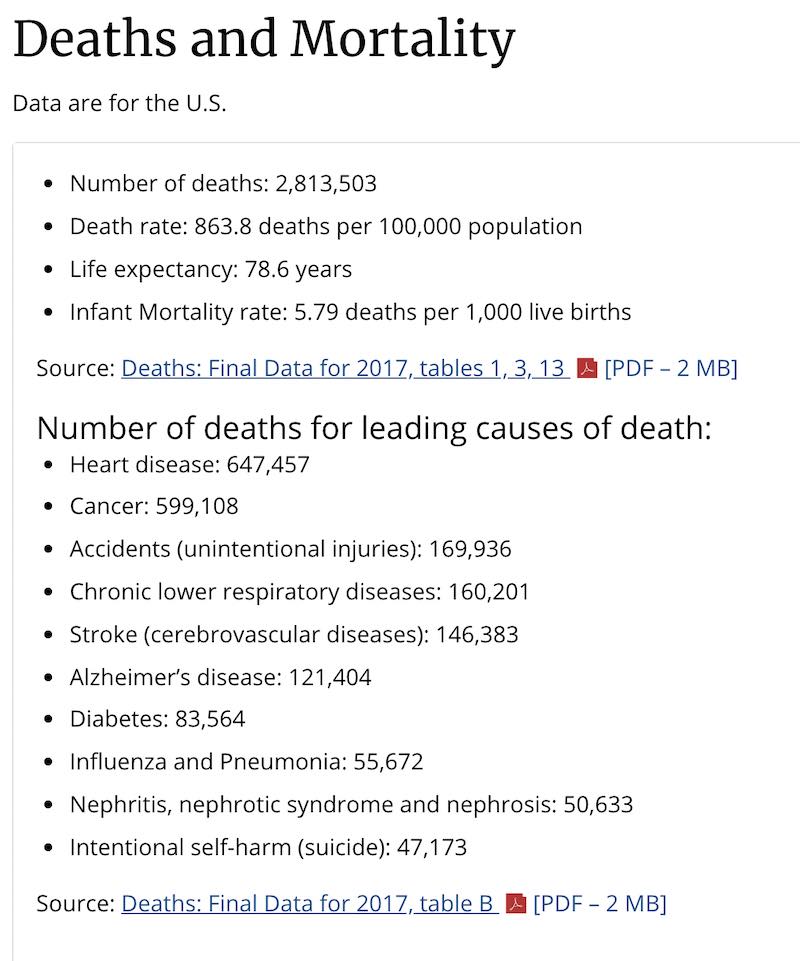

对比一下其它死因吧。美国 2017 年总共死亡 281 万人,其中因心脏病死亡 64.7 万人,癌症 59.9 万,呼吸道疾病 16 万,中风 14.6 万,意外伤害死亡 16.9 万(包括车祸),糖尿病 8.3 万,流感 5.5 万,自杀 4.7 万。

意外伤害死亡的 16.9 万里面包括了车祸的 3.7 万,所以另外 13.2 万人死于其它的意外。连自杀都有 4.7 万人。所以你可能意识到了,车祸死亡 3.7 万人并不是一个那么可怕的数字,而是相对来说最安全的领域之一了。

你知道车祸死掉的都是什么人吗?他们是怎么开的车?只要自己小心开车,我不觉得自己的风险会有那么高,可能比自杀的概率都要小。

Elon Musk 在采访中把汽车叫做“two-ton death machine”(两吨重的死亡机器),甚至说“难以置信我们居然允许人开车”,根本就是危言耸听。盲目的强调车祸死亡人数,号称可以降低事故率,就是自动驾驶领域常见的幌子。他们解决的并不是一个那么重要的问题,而且解决的方法根本就是不切实际的忽悠。

所以 Tesla 不但在技术上无法实现自动驾驶,而且人品和诚信都很成问题。我还没有见过一个汽车公司如此急于推脱责任的,一般都是积极配合调查,勇于承担责任,及时整改,这样才可能得到公众的信任。